- データの関連性を同時に計算する計算モデルのこと!

- それが文脈の重要度を判断し、大量の情報を高速に処理する役割を果たします。

- 現場で使うと翻訳や文章生成の精度が劇的に向上するという良い変化があります。

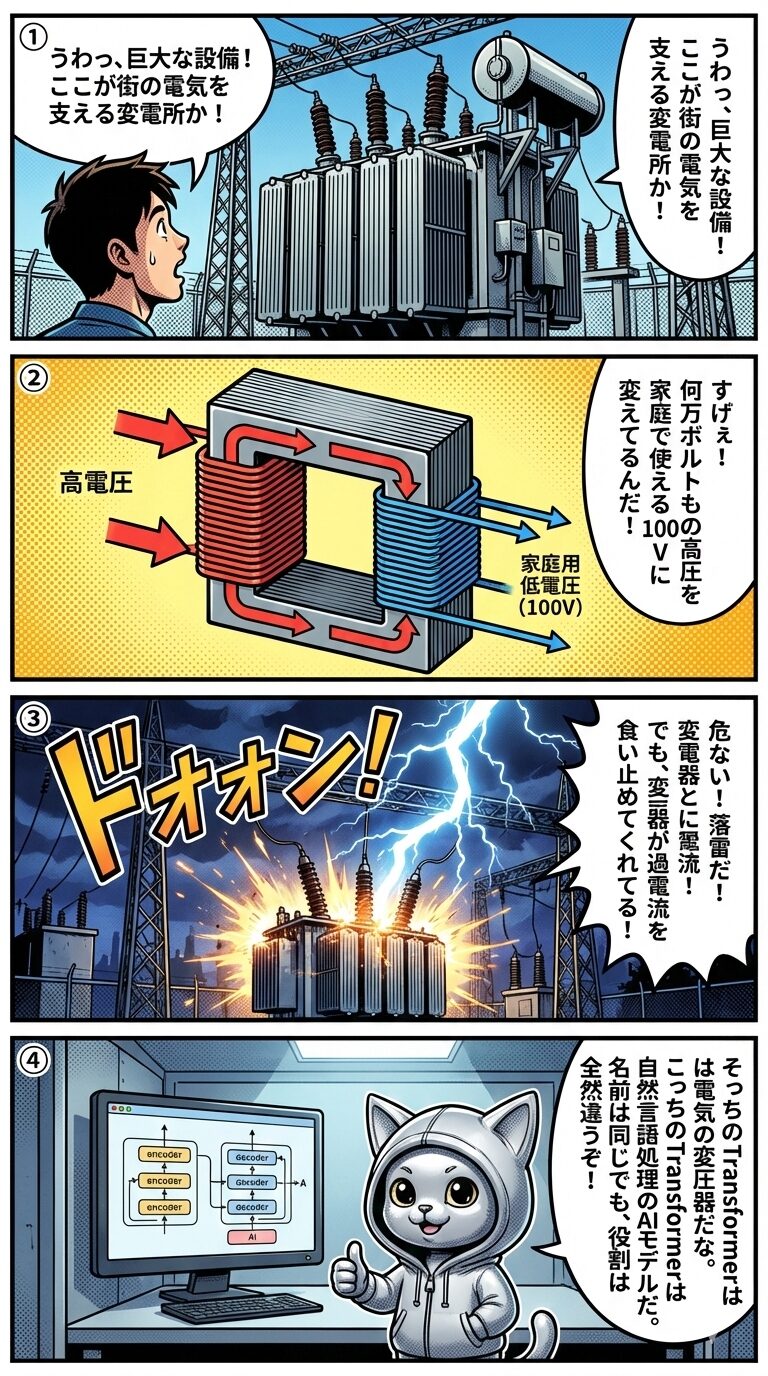

漫画の前半で描かれているのは電力インフラにおける物理的な機器ですが、ITの現場でTransformerという言葉が使われる場合、全く異なる技術を指すことが一般的です。それは自然言語処理などの分野で革命を起こしたデータの関連性を同時に計算する計算モデルのことです。

従来のAIモデルはデータを時系列順に処理する必要がありましたが、Transformerは並列処理によって文中の単語同士の関係性を一度に把握します。これにより学習時間が大幅に短縮され、翻訳や文章生成の精度が飛躍的に向上しました。

同じ名称であっても、物理的な電力供給を安定させる装置と、高度な情報処理を担うニューラルネットワークアーキテクチャでは役割が根本的に異なります。ITエンジニアやデータサイエンティストは、文脈に応じてどちらの技術を指しているかを正確に理解し使い分ける必要があります。

【深掘り】これだけ知ってればOK!

Transformerは、2017年に発表されたアテンション(注意)という仕組みを核としたモデルです。従来のAIは情報を端から順番に読み込んでいましたが、Transformerはすべてのデータを一度に俯瞰して、どの単語が重要かを瞬時に判断します。この革新的なアプローチが、現在のChatGPTなどの基盤となっています。

会話での使われ方

今回のチャットボット、Transformerベースのアーキテクチャを採用することにしました。

システム開発の選定会議で、なぜその技術を使うのかという技術的根拠を提示する場面です。

精度を出すためには、やはりセルフアテンションの調整が鍵になりますね。

開発チーム内での進捗確認で、モデルの性能を向上させるための具体的な注力ポイントを共有しています。

君の書いたコード、まるでTransformerのように文脈を読み取って最適化されているね!

先輩が後輩のコードを褒める際に、最新技術の特性をなぞらえて感心している場面です。

【まとめ】3つのポイント

- 情報の交通整理人:膨大な単語の中から、関連性の高いもの同士を瞬時に結びつける役割

- 並列処理によるスピード感:順番待ちをせずに一斉に処理を行うことで、学習時間を大幅に短縮

- 高精度な文章理解:文の前後関係を正確に把握することで、自然で人間らしい回答を実現

よくある質問

- QTransformerはいつ使うのがベストですか?

- A大量のテキストデータを分析したり、高精度な文章生成・翻訳システムを構築したい場合に最適です。

- QTransformerを失敗させないコツはありますか?

- A解かせたい課題に対して十分な学習データ量を確保することと、適切なハードウェア環境を整えることです。

- QTransformerの具体例は何ですか?

- A代表的なものにBERTやGPTシリーズ、Google翻訳の基盤システムなどがあります。

- QTransformerと従来のRNNとの違いは何ですか?

- A並列処理ができるかどうかが最大の違いです。RNNは順次処理ですが、Transformerは一括処理を行うため効率的です。

コメント